как алгоритмы заставляют нас «шептаться» в социальных сетях

Если вы провели хотя бы немного времени в TikTok, Instagram, Facebook или YouTube, вы, вероятно, встречали людей, говорящих «неживой» вместо «мертвый», «сеггс» вместо «секс» или говорящих о «музыке» и «фестивалях», когда на самом деле они говорят о протестах и чувствительных политических темах. Это не просто интернет-шутка, это способ, которым миллионы пользователей пытаются обмануть алгоритмы, которые, по их мнению — иногда справедливо, иногда просто из коллективной паранойи — могут похоронить их контент, если они будут использовать «неправильные» слова.

Люди больше не «умирают» в социальных сетях, они «неживы». Секс становится «сегсом», оружие — «пиу-пиу», а наркотики — «д» или «особыми пирожными». Те, кто постоянно пользуется Facebook, TikTok, Instagram или YouTube, точно знают, о чем идет речь: закодированный язык, изобретенный не для того, чтобы быть более креативным, а из-за страха, что алгоритмы скроют или накажут контент, в котором используются определенные прямые слова.

У этого явления уже есть название: альгоязык. И согласно анализу, проведенному BBC, речь идет не просто о шутках или интернет-жаргоне, а о форме коллективной самоцензуры, порожденной страхом перед алгоритмами и непрозрачными правилами больших платформ.

Мир, где «музыка» на самом деле означает протесты

В последние годы Algospeak стремительно развивается, поскольку создатели контента все чаще чувствуют, что их наказывают за высказывания. Некоторые отмечают в своей статистике, что когда они используют такие термины, как «YouTube» в клипе TikTok, или пытаются перенаправить людей на другую платформу, количество просмотров резко падает. Официально компании отрицают наличие у них «секретных списков запрещенных слов». Он уверяет нас, что «такого не бывает», что все зависит от контекста и соблюдения правил сообщества.

Но реальность сложнее. История этих платформ полна эпизодов, в которых было доказано, что они незаметно манипулировали тем, что происходит в ленте: от политического контента до сообщений о меньшинствах, протестах или войне. TikTok, например, признал, что у него есть внутренняя кнопка «нагрева», с помощью которой он может вручную сделать определенные видео вирусными. Если можно нажать «нагреть», почему нельзя также нажать «охладить», говорят создатели.

Знаменитый «музыкальный фестиваль» также появился в этой атмосфере. Летом 2025 года в США люди вышли на улицы в знак протеста против рейдов иммиграционной службы ICE. В TikTok и Instagram вместо того, чтобы прямо сказать «протест» или «демонстрация», создатели заговорили о «большом музыкальном фестивале в Лос-Анджелесе», фактически показывая толпы протестующих с плакатами в кадре. Код был понятен «посвященным»: если вы скажете «протест», алгоритм вас отключит; если вы скажете «музыкальный фестиваль», клип пропадет.

Ирония, по словам исследователей, заключается в том, что нет четких доказательств того, что платформы систематически подвергали эти протесты цензуре. Люди представляли, что это происходит, заранее адаптировались, и именно используемый код — «музыкальный фестиваль» — сделал клипы вирусными, потому что каждый хотел стать частью «шутки».

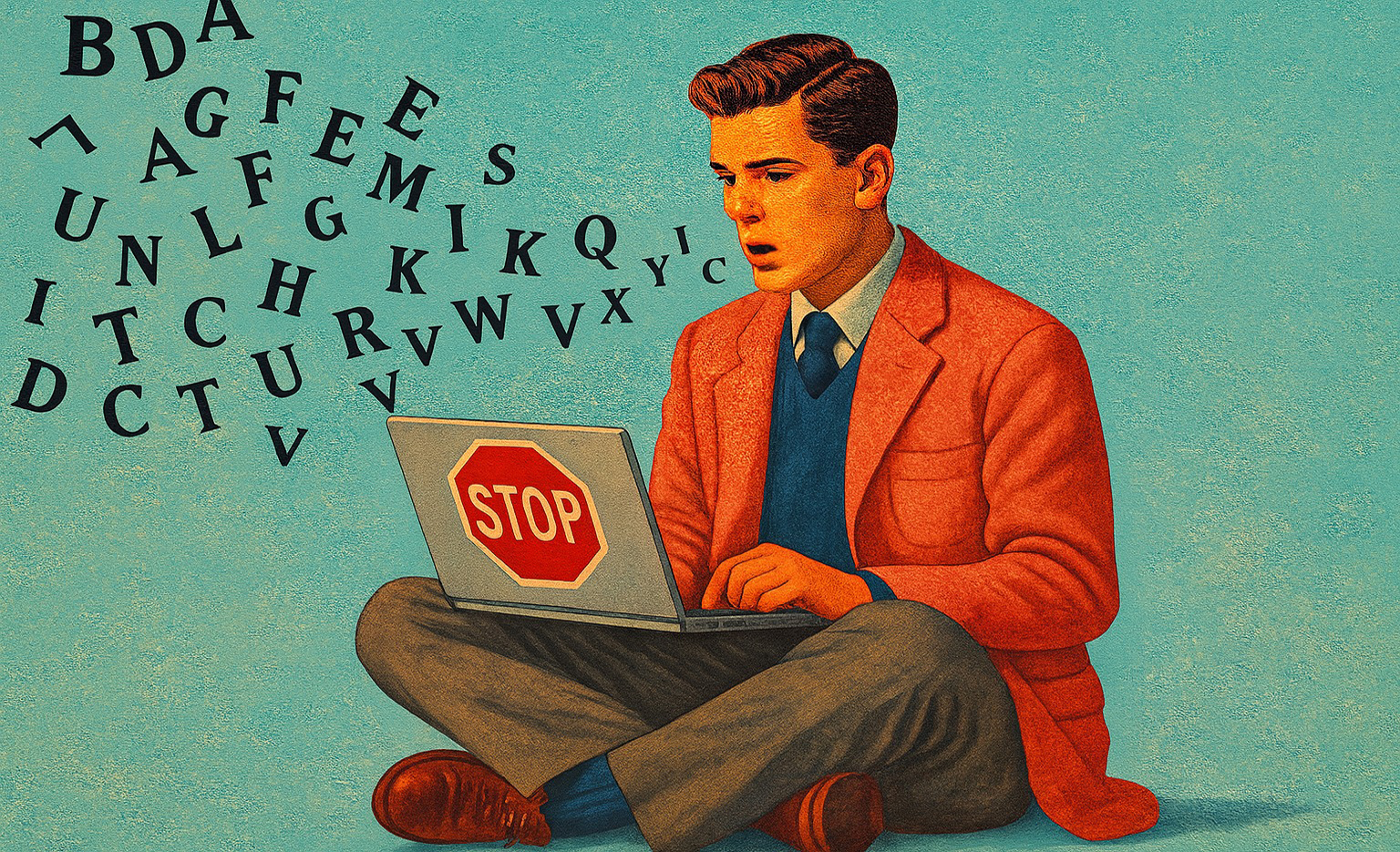

Крупные платформы, такие как TikTok, Meta и YouTube, отрицают, что у них есть секретные списки запрещенных слов, но их послужной список показывает непрозрачные вмешательства в продвижение или сокрытие определенных тем, разжигая подозрения и самоцензуру. (Иллюстрация Playtech с искусственным интеллектом)

Когда «Остров» означает Эпштейна, а «сеггс» заменяет секс

Другой пример – случай Джеффри Эпштейна. Американский автор рассказал Би-би-си, что после того, как несколько его видеороликов о скандальном финансисте были удалены, он начал называть его «Островным человеком», имея в виду свой частный остров. Ролики остались в сети, но часть публики уже не поняла, кто это.

То же самое происходит и в румынском языке. В TikTok и Instagram вы можете увидеть, как подростки и молодые люди пишут «seggs» вместо «sex», «unalive» вместо «kill», «ds» или «cakes», когда хотят поговорить о наркотиках, «сексе» или «цветных квадратах» вместо таблеток. Все признают, что это звучит смешно, но мало кто рискует протестировать прямую версию, опасаясь исчезновения из своей ленты или демонетизации своего контента.

У социологов и лингвистов есть термин для обозначения этого явления: «алгоритмическое воображаемое». Мы больше не реагируем на четкие и явные правила, а реагируем на то, что, по нашему мнению, алгоритмы хотят увидеть или скрыть. Даже если платформы настаивают на том, что они не блокируют списки слов, того простого факта, что правила непрозрачны и что они иногда ошибаются или применяют модерацию выборочно, достаточно, чтобы миллионы людей подвергают самоцензуре.

Со временем эта игра в «обход системы» становится частью онлайн-культуры: мы придумываем новые слова, мемы, инсайдерские шутки, которые играют роль обмана реальных или воображаемых фильтров. Просто вместо того, чтобы развязать речь, они могут усложнить понимание, особенно тем, кто не живет постоянно в сетях.

В отсутствие реальной прозрачности пользователи меняют свое поведение в зависимости от того, чего, по их мнению, «хочет» алгоритм, и эта коллективная самоцензура рискует ограничить общественные дебаты и доступ к конфиденциальной информации. (Иллюстрация Playtech с искусственным интеллектом)

Кто решает, что нам на самом деле разрешено видеть?

Помимо политических споров, реальная ставка является экономической. Платформы живут за счет рекламы. Их цель – не обязательно «контролировать общественную дискуссию», а обеспечить достаточно «чистый» поток контента, чтобы не отпугнуть бренды или регуляторов.. Когда тема рискует стать слишком токсичной, слишком жестокой или слишком «неудобной», велик искушение незаметно нажать на тормоза.

Вот так мы и оказываемся в мире, где никогда не знаем, почему клип не цепляется: вы использовали «запрещенное» слово? Вы затронули деликатную тему? Или это было просто не интересно? В этом информационном пробеле люди изобретают свои собственные теории и меняют свое поведение. Сами того не осознавая, мы говорим зашифрованно, избегая определенных тем или формулировок. просто чтобы «не нарушать алгоритм».

Для растущей аудитории социальные сети являются основным источником информации. Если идеи циркулируют только шепотом, через шутки и кодексы, которые понимает только «правильный пузырь», риск прост: некоторые чувствительные темы, от злоупотреблений до коррупции или гражданских прав, в конечном итоге становятся видимыми все меньшему и меньшему количеству людей.

Платформы говорят нам, что они просто хотят «защитить» нас и предоставить нам безопасную среду. Но пока мы не знаем точно, как работают их алгоритмы и за что именно они наказывают, самоцензура и альгоязык будут продолжать расти. И остается неловкий вопрос: кто на самом деле контролирует публичный разговор — мы или несколько гигантов, живущих за счет нашего внимания?