Когда искусственный интеллект сумасшедший: Paypal Chatbot поздравил жертву мошенничества

Искусственный интеллект становится все более и более присутствующим в повседневной жизни, от чат -ботов и виртуальных помощников до рекомендаций генераторов изображений и алгоритмов. Тем не менее, ИИ не является непогрешимым, и иногда он терпит неудачу неожиданным и даже забавным способом. Два недавних примера прекрасно иллюстрируют, как технологии могут неверно истолковывать ситуации и дать абсурдные результаты.

Вирусный случай в Твиттере вызвал интенсивные дискуссии о пределах ИИ и о том, насколько хорошо понимается контекст разговора. Пользователь платформы PayPal сообщил о мошенничестве через чат -бот компании, ожидая, чтобы получить помощь, чтобы восстановить свои деньги или, по крайней мере, подтверждение того, что его проблема воспринимается всерьез, я пишу NewsProtv. Вместо этого чат -бот поздравился с его «успехом», не понимая, что это была афера.

Этот варенье стало быстро вирусным, пользователи, гладящие роботизированные реакции, и подчеркивают риски, позволяя ИИ управлять чувствительными проблемами без наблюдения за человеком. Хотя технология прогрессирует быстро, такие ошибки показывают, что современные модели ИИ не могут полностью понять эмоции и оттенки человеческого разговора.

Такие ошибки поднимают серьезные вопросы об использовании искусственного интеллекта в службах поддержки клиентов. Вместо того, чтобы помочь, ИИ может усугубить ситуацию, разочаровывать пользователей и повлиять на репутацию компании. В случае PayPal эта ситуация была явным примером того, что чат -боты должны быть лучше обучены обнаружить критические ситуации и предоставить соответствующие ответы.

ИИ человека и анатомия-безуспешная комбинация

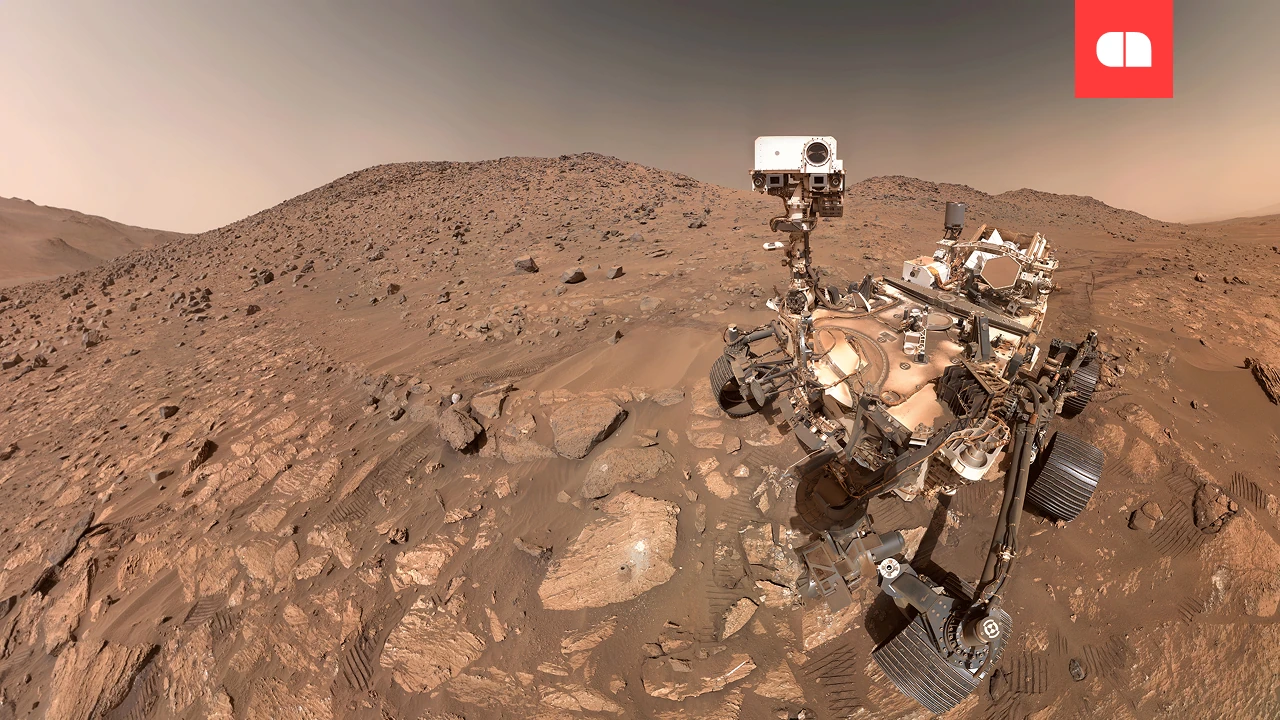

Еще один странный пример того, как ИИ может сорваться, исходит из школы США, где учитель пытался использовать технологии для создания образовательных изображений об анатомии человека. Теоретически, ИИ должен был создать правильные и подробные представления человеческого тела, но результаты были далеко не точными.

Сгенерированные изображения имели неправильные пропорции, мышцы и кости, размещенные в невозможных местах и описаниях, которые не имели никакого отношения к реальности. Вместо того, чтобы быть полезным инструментом для образования, ИИ создал серию деформированных и ошибочных представлений, ставя под сомнение доверие к таким технологиям в академических целях.

Этот инцидент подчеркнул важный аспект: ИИ не является непогрешимым и не должен использоваться без проверки человека, особенно в таких областях, как образование или медицина, где важна точность информации. Хотя искусственный интеллект может революционизировать то, как мы учимся и работаем, его следует использовать с осторожностью и всегда контролируется человеческими специалистами.

Искусственный интеллект нуждается в лучших правилах

Эти примеры — только два из многих случаев, когда ИИ удивительно провалился. Из чат -ботов, которые не понимают контекст неправильно сгенерированных изображений, ясно, что технологии еще не находятся на уровне человеческого понимания.

В будущем для разработчиков важно создавать более сложные алгоритмы, способные лучше интерпретировать намерения пользователей и избежать абсурских ошибок. До этого ИИ остается сильным инструментом, но с очевидными ограничениями, которые требуют постоянного наблюдения и регулировки для эффективной функции