OpenAI признает риск искусственного интеллекта: его модели ИИ можно использовать для создания биологического оружия

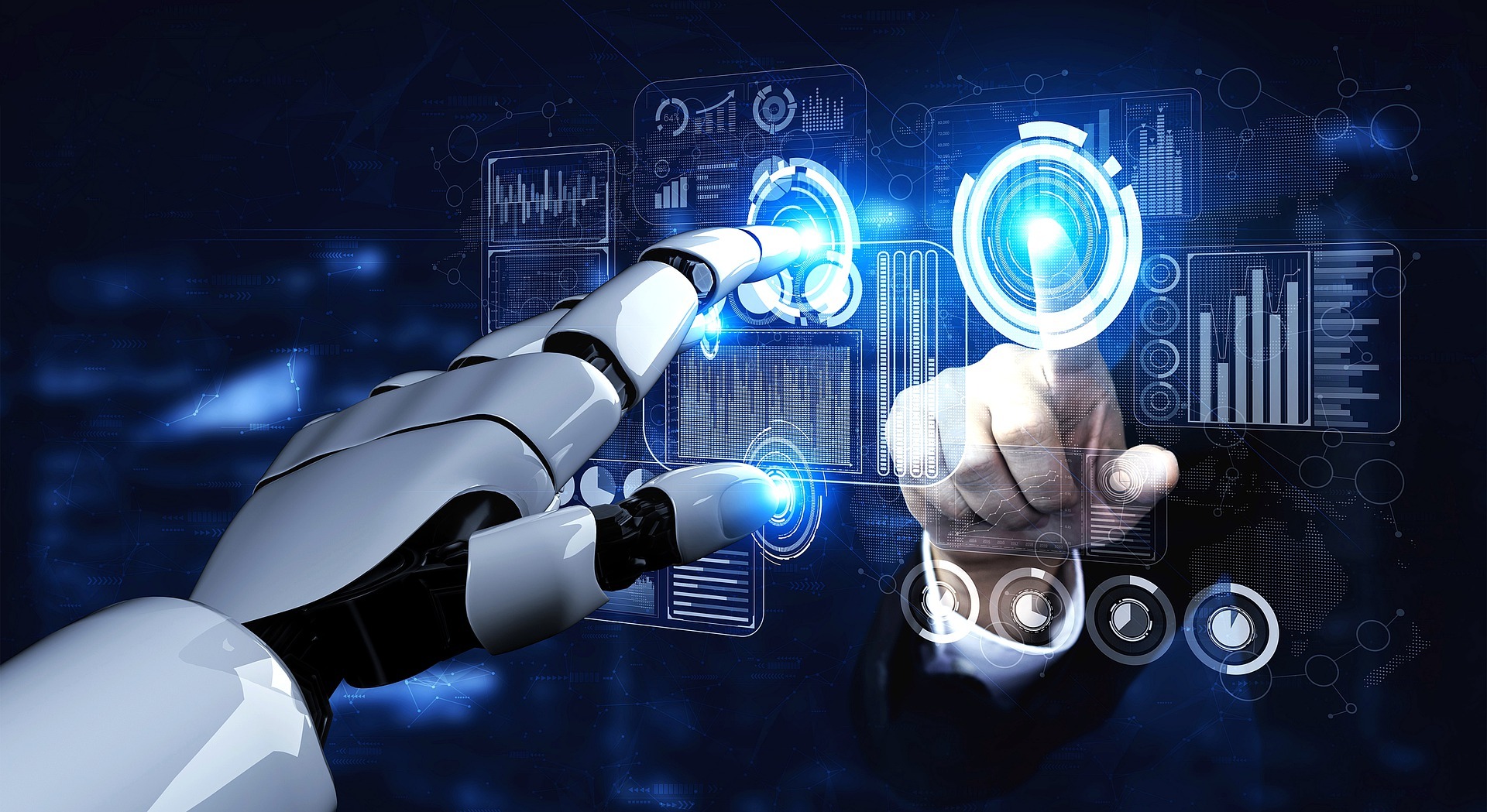

Американская компания признает, что ее будущие модели могут поддерживать репликацию или развитие опасных биологических агентов, хотя она утверждает, что она требует строгих мер безопасности.

В недавнем заявлении Openai признала, что его новые модели искусственного интеллекта, развивающиеся, могут достичь уровня изысканности, который позволит им помочь в разработке биологических агентов с потенциальным разрушительным.

В то время как компания подчеркивает полезность технологий в медицинских исследованиях и биологической защите, она признает, что та же технология может быть направлена в опасных целях, включая поддержку биологического оружия, пишет футуризм.

Заявление содержится в официальной статье, опубликованной в блоге Openai, где компания рассказывает о балансе, чтобы сбалансировать научные инновации с ограничением доступа к конфиденциальной информации.

Другими словами, хотя модели ИИ могут помочь в прогрессе медицины или профилактики пандемии, существует риск того, что они также будут способствовать действиям с существенным негативным влиянием на здравоохранение.

Будущие модели могут поддерживать пользователей без продвинутого обучения

Йоханнес Хайдеки, менеджер по безопасности OpenAI, сказал в интервью для текущих моделей, которые не могут полностью генерировать новые биологические агенты, но могут способствовать репликации некоторых уже известных.

По его словам, проблема заключается в том, что эти модели могут оказать достаточную поддержку даже людям без продвинутых биологических навыков, что повышает специальный риск для глобальной безопасности.

«Мы до сих пор не сталкиваемся с совершенно новыми угрозами, неизвестными в области синтетической биологии, но мы приближаемся к этому моменту», — сказал Хайдеки.

В частности, он упомянул, что некоторые из преемников текущей модели, называемой O3, могут достичь этого критического уровня производительности в ближайшем будущем.

OpenAI утверждает, что его стратегия ориентирована на профилактику, а не реакцию. Таким образом, компания хочет внедрить фильтры и системы мониторинга, которые обнаруживают рискованное использование ИИ с зарождающихся этапов.

Тем не менее, Хайдеки предупреждает, что требуемый уровень точности почти абсолютный: «Модели недостаточно обнаружить 99% опасных случаев. Даже один побег может иметь разрушительные последствия».

Противоречия и вопросы об использовании для государственных целей

Несмотря на обязательство, объявленное для безопасности, OpenAI, по -видимому, не тормозит темпы развития этих технологий. Напротив, компания участвует в «биодных» проектах, в том числе в сотрудничестве с правительствами, которые вызывают обеспокоенность по поводу потенциальных сбоев.

Критики указывают на то, что технология с такими способностями в руках государственного актера с сомнительными интересами может быть направлена в репрессивных или военных целях.

Кроме того, возникает вопрос, который устанавливает моральные и юридические ограничения использования этих систем, как только они становятся частью технологического арсенала сверхдержавы.